Lo scopo di questa controreplica è valutare nel merito gli argomenti tecnici con cui Lorenzo Rampa ha replicato alle critiche mosse nei confronti della valutazione della ricerca condotta con lo strumento bibliometrico Scholar Search, un interfaccia informatica per interrogare Google Scholar messa a punto dal gruppo di Biologia Molecolare di Roma Tor Vergata. Come spiegato in dettaglio, le argomentazioni di Rampa non sembrano reggere il confronto con i dati e, invece che dissiparli, aggravano i dubbi sull’adeguatezza della valutazione bibliometrica adottata dall’università di Pavia negli ultimi anni.

Lo scopo di questa controreplica è valutare nel merito gli argomenti tecnici con cui Lorenzo Rampa ha replicato alle critiche mosse nei confronti della valutazione della ricerca condotta con lo strumento bibliometrico Scholar Search, un interfaccia informatica per interrogare Google Scholar messa a punto dal gruppo di Biologia Molecolare di Roma Tor Vergata. Come spiegato in dettaglio, le argomentazioni di Rampa non sembrano reggere il confronto con i dati e, invece che dissiparli, aggravano i dubbi sull’adeguatezza della valutazione bibliometrica adottata dall’università di Pavia negli ultimi anni.

Prima di passare alla disamina degli argomenti, va ringraziato Lorenzo Rampa, non solo per avere inviato una lunga e argomentata replica all’articolo “Un riparto difficile: il backstage del piano triennale pavese“, ma anche per aver messo a disposizione in forma disaggregata i dati estratti da Scholar Search che erano stati usati per la valutazione della ricerca dell’ateneo pavese.

Per comodità, riassumiamo i motivi per cui Cristina Barbieri ed io ritenevamo Scholar Search uno strumento amatoriale e inadatto alla misurazione della ricerca di un ateneo come quello pavese.

- Mancanza di validazione scientifica. Scholar Search estrae le informazioni da Google Scholar, un database bibliometrico il cui uso per scopi di valutazione è esplicitamente sconsigliato dalla letteratura bibliometrica.

- Falsi negativi. Prendendo come cavia il neo-rettore Fabio Rugge, abbiamo mostrato che nelle discipline umanistiche la copertura di Scholar Search restituisce una percentuale alquanto bassa della reale produzione dei soggetti valutati. Che non si trattasse di evidenza aneddotica era confermato dal numero esiguo di pubblicazioni che Scholar Search attribuiva all’intera Area 14 di Scienze Politiche e Sociali.

- Falsi positivi. Restava irrisolto il problema della disambiguazione dei cognomi, al punto che nella classifica della produttività e delle citazioni Scholar Search metteva ai primi posti dell’Area 14 tre ricercatori il cui vero “merito” era avere lo stesso cognome e le stesse iniziali di colleghi pavesi che lavoravano nelle scienze dure, dove la copertura bibliometrica è assai più completa.

A causa dei falsi positivi e dei falsi negativi, un’area umanistica, come Scienze politiche e sociali, si vedeva privata della maggioranza delle sue pubblicazioni, mentre gli apparenti picchi di produttività individuale, capaci di influenzare la performance collettiva, erano dovuti a falsi positivi frutto di omonimie con ricercatori delle scienze dure. In presenza di dati così arbitrari, confidare nelle compensazioni statistiche, sembrava più l’invocazione di un deus ex machina che una scelta razionale.

Riguardo alla prima obiezione, Rampa non ha opposto argomenti. Piuttosto, ha cercato di mostrare che gli altri due argomenti non sono tali da poter emettere una condanna senza appello nei confronti di Scholar Search. L’argomentazione di Rampa si sviluppa in tre passi:

- Le valutazioni ed i riparti di risorse dell’ateneo non risentono di una percentuale esorbitante di falsi positivi, perché le interrogazioni erano state effettuate con una versione precedente di Scholar Search che si avvaleva di una opzione di Google Scholar, successivamente rimossa, che consentiva il filtraggio per Macro-Aree. Grazie a tale opzione, i dati di Area 14 effettivamente usati per la valutazione pavese non sarebbero stati inquinati dalle massicce iniezioni di pubblicazioni apocrife evidenziate dal nostro articolo.

- I falsi negativi erano “una circostanza nota, tale da rendere certamente inaffidabili gli indicatori individuali” ma potevano essere “(secondo alcuni) provvisoriamente accettabili quelli aggregati“. Infatti, essi erano stati normalizzati su una scala nazionale che vede tutti gli atenei ugualmente soggetti ad un’alta percentuale di falsi negativi nella aree a bassa copertura bibliometrica.

- Per valutare “quanto sia stato azzardato e (gravemente) compromissorio utilizzare in via provvisoria l’indice stesso anche per Aree con un basso tasso di copertura della produzione scientifica” Rampa effettuata una comparazione con i risultati della VQR. Secondo Rampa, tra l’indicatore di Scholar Search e quello della VQR “si notano una discreta correlazione ed una accettabile co-graduazione“. In altre parole, Scholar Search avrebbe anticipato, almeno approssimativamente, i risultati della VQR, che – si noti bene – sono immuni da problemi di falsi negativi e positivi.

È chiaro che l’ultimo argomento è il più forte. Immaginiamo per un attimo che le spericolate approssimazioni di Scholar Search diano gli stessi risultati dell’apparato forse controverso, ma comunque minuzioso, della VQR. Se così fosse, Barbieri e De Nicolao avrebbero sollevato tanto rumore per nulla. “Surtout pas trop de zèle” raccomanda saggiamente Rampa.

Ma le cose stanno proprio così?

1. “Temporibus illis”, Google Search era davvero più affidabile?

È vero: fino a primavera 2012 era possibile ricorrere al filtraggio per macro-aree, grazie al quale la percentuale di pubblicazioni apocrife attribuite agli umanisti sarebbe risultata assai minore dei numeri evidenziati da Barbieri e De Nicolao. C’è però un prezzo da pagare, come spiega Antonio Banfi in quell’articolo (Scholar Search: all’inferno andata e ritorno) che Rampa definisce “polemico pamphlet“. In realtà, tra un’arguzia e l’altra, il “pamphlet” compie un’analisi tecnica delle falle di Scholar Search, mettendo in evidenza che la sua copertura bibliometrica si comporta come la più classica delle coperte corte che, quando viene tirata sulle spalle, lascia scoperti i piedi. Fino a maggio 2012, era sì possibile usare il filtraggio per macro-aree, arginando il flusso di pubblicazioni apocrife dalle scienze dure verso quelle umane e sociali, ma il prezzo da pagare era l’esplosione degli pseudo-fannulloni.

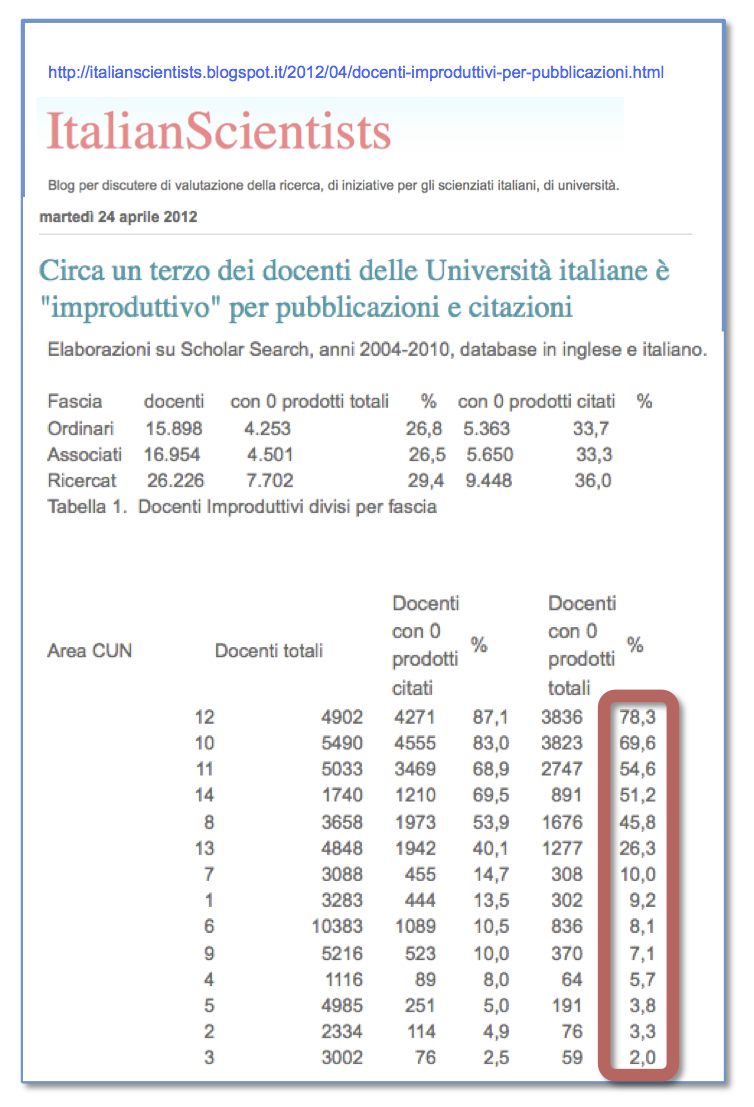

Per verificare in che misura Scholar Search “gonfiava” le percentuali di fannulloni consultiamo un post pubblicato il 24 aprile 2012 sul blog Italian Scientists. Si trattava di un articolo, dal tono allarmistico, intitolato

Circa un terzo dei docenti delle Università italiane è “improduttivo” per pubblicazioni e citazioni

Per calcolare le percentuali di inattivi nelle quattordici aree CUN (vedi sopra) ed anche nei singoli SSD (vedi qui), era stato utilizzato proprio Scholar Search. Se i risultati fossero stati veri, le aree umanistiche (aree 10-14) sarebbero state dei veri covi di fannulloni, con percentuali dal 26,3% (Area 13 – Scienze economiche e sociali) fino al 78,3% di Scienze giuridiche. Anche l’Area 8 (Ingegneria civile ed architettura) destava scandalo con il suo 45,8% di inattivi totali. I risultati, però, erano del tutto inaffidabili.

Per calcolare le percentuali di inattivi nelle quattordici aree CUN (vedi sopra) ed anche nei singoli SSD (vedi qui), era stato utilizzato proprio Scholar Search. Se i risultati fossero stati veri, le aree umanistiche (aree 10-14) sarebbero state dei veri covi di fannulloni, con percentuali dal 26,3% (Area 13 – Scienze economiche e sociali) fino al 78,3% di Scienze giuridiche. Anche l’Area 8 (Ingegneria civile ed architettura) destava scandalo con il suo 45,8% di inattivi totali. I risultati, però, erano del tutto inaffidabili.

La spiegazione era relativamente facile e va ad Antonio Banfi il merito di averla resa pubblica. All’epoca, Google Scholar manteneva una catalogazione delle pubblicazioni in macro-aree, ma una consistente percentuale di pubblicazioni risultava non catalogata. Queste pubblicazioni prive di etichetta, una specie di “materia oscura”, comprendevano una grossa fetta della produzione umanistica. Se si usavano i filtri di macro-area, la materia oscura rimaneva invisibile al telescopio di Google Scholar, con il risultato di moltiplicare a dismisura la percentuale di “umanisti fannulloni” (esplosione di falsi negativi). Se però si interrogava il database senza filtri – scelta che attualmente è l’unica possibile – ricompariva la materia oscura ma, insieme ad essa, la valanga di pubblicazioni e citazioni apocrife provenienti dagli omonimi delle scienze dure (esplosione di falsi positivi).

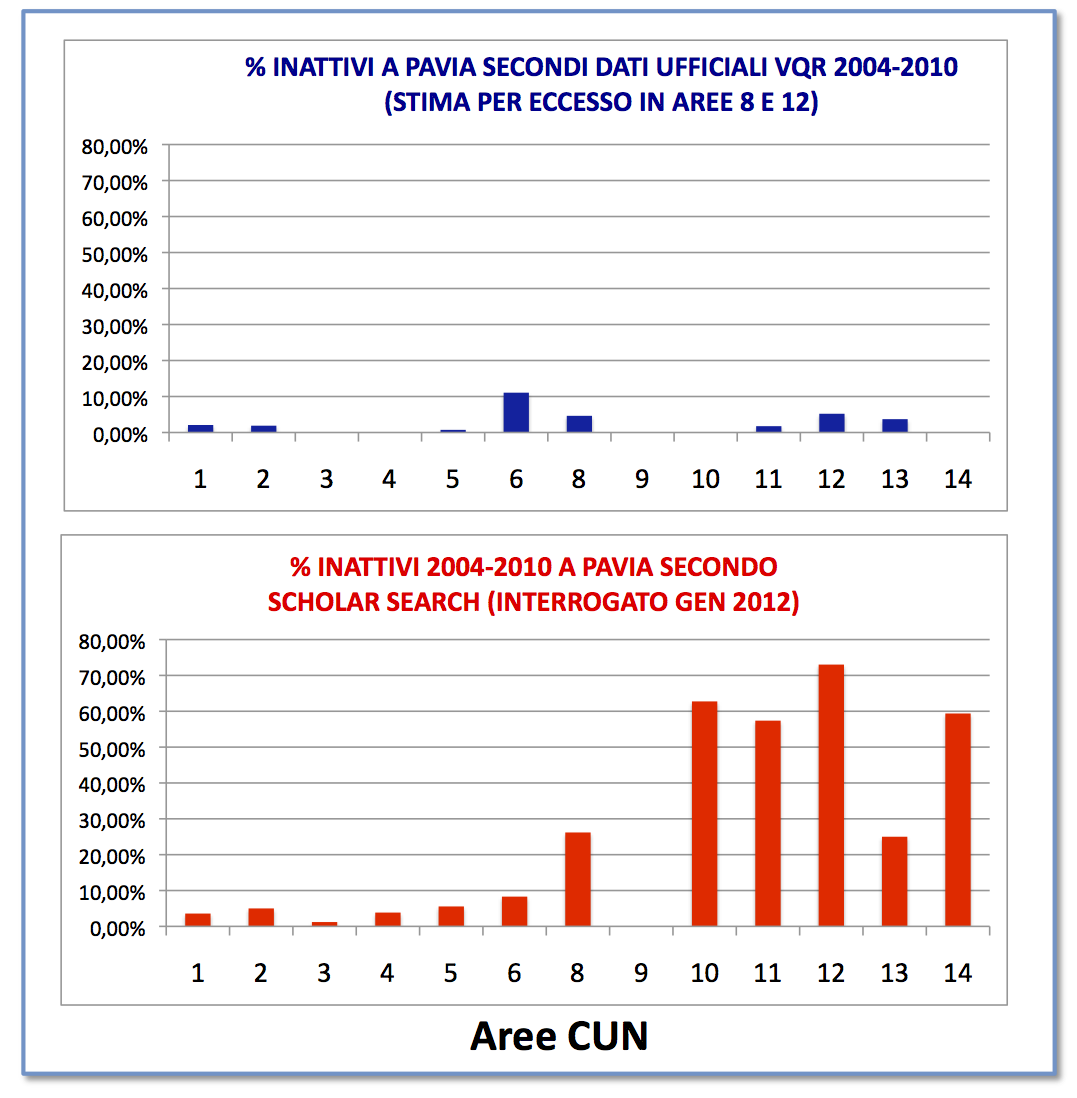

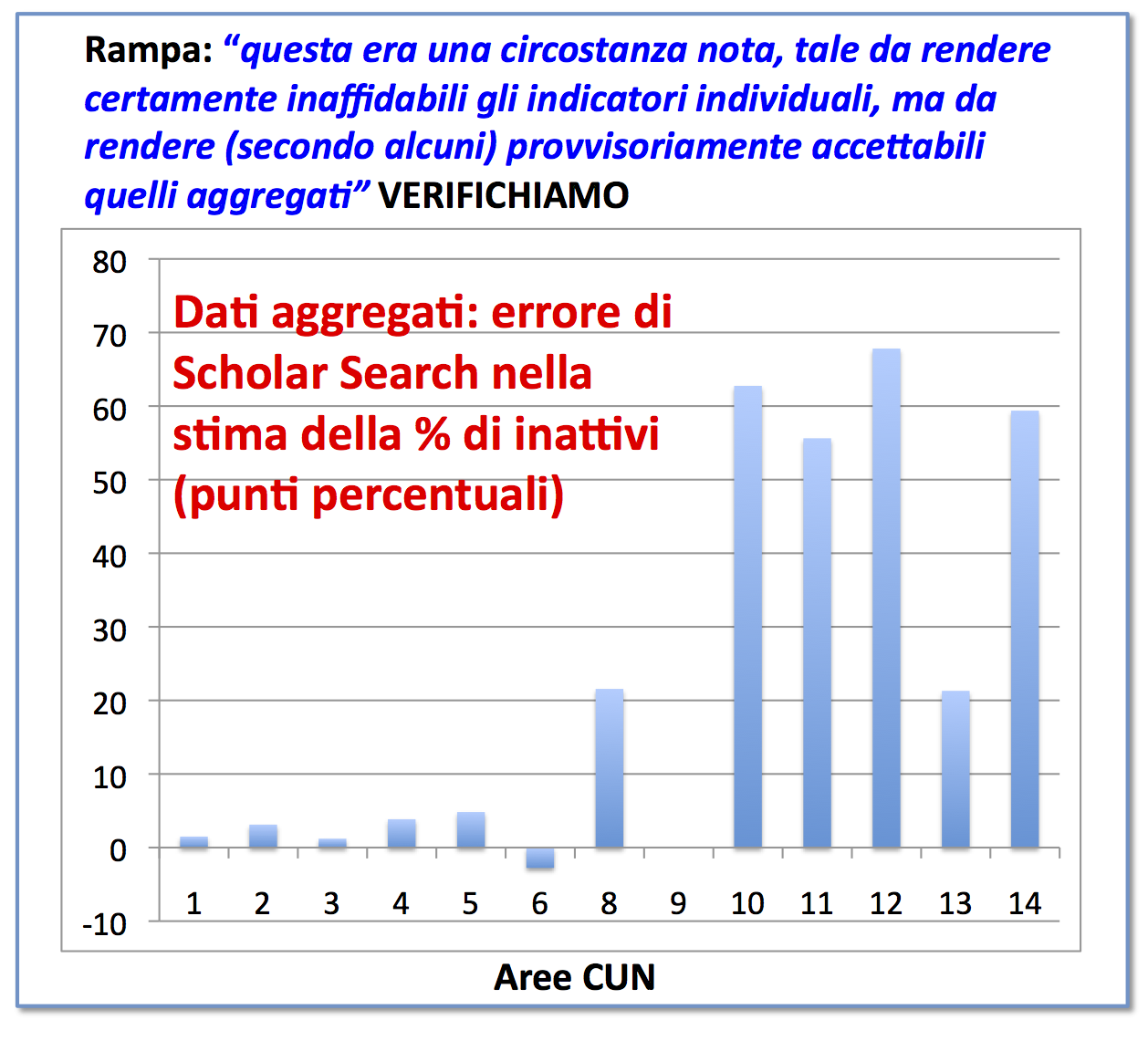

È pertanto discutibile sostenere che le interrogazioni del gennaio 2012 fossero più affidabili di quelle odierne. I dati scaricati da Scholar Search nel 2012 – e utilizzati nella valutazione della ricerca pavese – hanno azzerato la produzione di gran parte degli umanisti. Per verificarlo, basta confrontare gli inattivi rilevati dalla VQR con i dati gentilmente forniti da Rampa.

Come si vede, la distorsione delle percentuali di inattività introdotta da Scholar Search nelle aree umanistiche è enorme. Nelle aree 10-14, secondo i dati ufficiali VQR, la percentuale di inattivi è sempre decisamente inferiore al 10%, mentre la ricerca dell’ateneo pavese è stata valutata con uno strumento bibliometrico che sovrastimava la percentuale di inattivi anche di 68 punti percentuali (Area 12 – Scienze giuridiche). Pure clamoroso è il caso dell’Area 10 (Scienze dell’antichità, filologico-letterarie e storico-artistiche) dove Scholar Search riteneva inattivo il 62,75% dei valutati mentre la vera percentuale è 0% (zero percento), secondo i dati ufficiali VQR.

Come si vede, la distorsione delle percentuali di inattività introdotta da Scholar Search nelle aree umanistiche è enorme. Nelle aree 10-14, secondo i dati ufficiali VQR, la percentuale di inattivi è sempre decisamente inferiore al 10%, mentre la ricerca dell’ateneo pavese è stata valutata con uno strumento bibliometrico che sovrastimava la percentuale di inattivi anche di 68 punti percentuali (Area 12 – Scienze giuridiche). Pure clamoroso è il caso dell’Area 10 (Scienze dell’antichità, filologico-letterarie e storico-artistiche) dove Scholar Search riteneva inattivo il 62,75% dei valutati mentre la vera percentuale è 0% (zero percento), secondo i dati ufficiali VQR.

Cosa scrive Rampa?

questa era una circostanza nota, tale da rendere certamente inaffidabili gli indicatori individuali, ma da rendere (secondo alcuni) provvisoriamente accettabili quelli aggregati

Per valutare se gli indicatori aggregati fossero “provvisoriamene accettabili” calcoliamo l’errore commesso nella stima della percentuale di soggetti inattivi.

Come si può vedere, se si esclude l’Area 13 (Scienze economiche e statistiche), in cui l’errore supera comunque i 20 punti, la sovrastima nelle altre aree umanistiche (Aree 10-12 e 14) è addirittura maggiore di 50 punti percentuali. Per quanto numericamente meno rilevanti, è interessante notare che nell’Area 6 abbiamo una sottostima: vuol dire che Scholar Search sottostima il numero di inattivi perché “regala” a docenti pavesi inattivi le pubblicazioni di qualche loro omonimo.

È vero che errori altrettanto grandi vengono commessi anche su scala nazionale. Però, l’idea che si possa presumere accettabile un dato pavese grossolanamente errato perché normalizzato con un altro dato nazionale, anch’esso grossolanamente errato, è un po’ come cercare di azzeccare i risultati di un esercizio di algebra commettendo un numero pari di errori di segno che si compensano a vicenda.

3. “Una discreta correlazione ed un’accettabile co-graduazione”

Ma veniamo al piatto forte che dovrebbe “sdoganare” Scholar Search. “Non importa se un gatto è bianco o nero, finché cattura i topi” diceva Deng Xiao Ping. Anche se Scholar Search mancasse di fondamento scientifico – sembra dirci Rampa – poco importerebbe se alla fine fornisce risultati più o meno equivalenti alla VQR. Ma il gatto cattura veramente il topo oppure fa la fine di Gatto Silvestro alle prese con Speedy Gonzales?

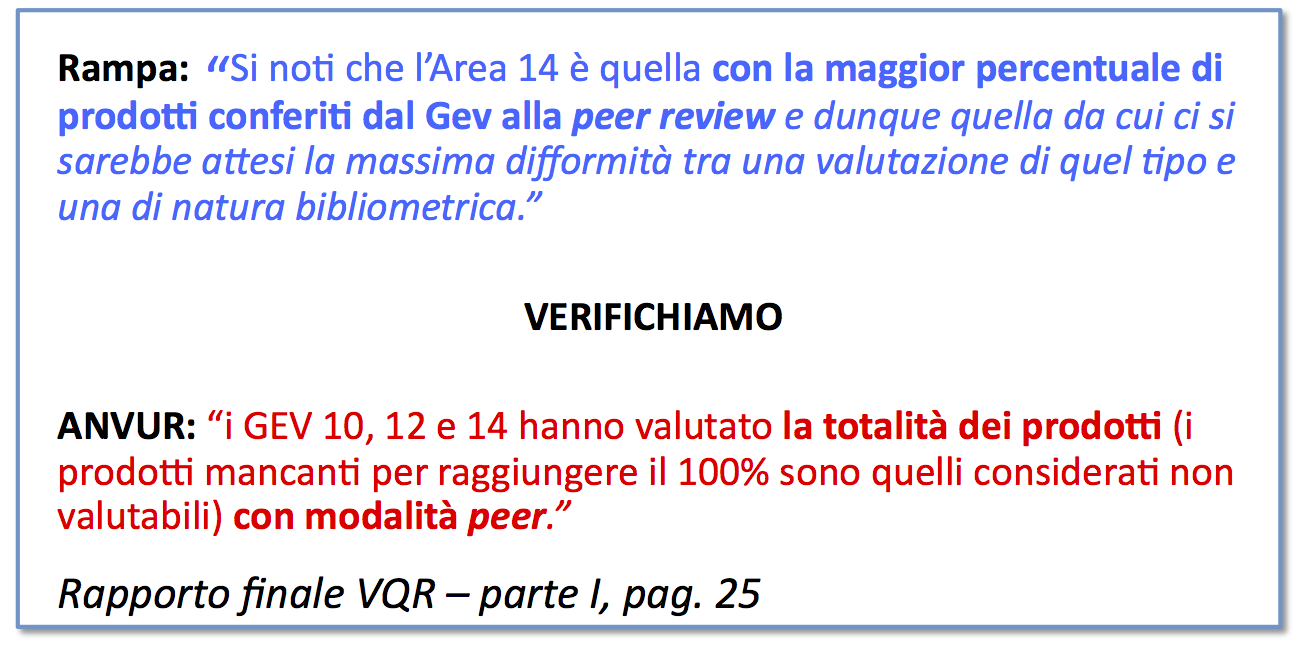

Incidentalmente, notiamo che Rampa commette una svista relativamente alle modalità con cui è stata condotta la VQR. Nel confrontare i responsi di Scholar Search con quelli della VQR constata con soddisfazione che essi sembrano concordare anche nell’Area 14, che sarebbe la meno bibliometrica di tutte:

Incidentalmente, notiamo che Rampa commette una svista relativamente alle modalità con cui è stata condotta la VQR. Nel confrontare i responsi di Scholar Search con quelli della VQR constata con soddisfazione che essi sembrano concordare anche nell’Area 14, che sarebbe la meno bibliometrica di tutte:

Si noti che l’Area 14 è quella con la maggior percentuale di prodotti conferiti dal Gev alla peer review e dunque quella da cui ci si sarebbe attesi la massima difformità tra una valutazione di quel tipo [peer review VQR – NdR] e una di natura bibliometrica [H norm di Scholar Search – NdR].

Affermazione che suona strana a chiunque conosca le procedure adottate dalla VQR nelle aree 10, 12 e 14. Infatti, non ha senso parlare di una sola area con maggiore percentuale di peer review rispetto alle altre perché, in tutte e tre, il 100% dei prodotti è passato attraverso la revisione dei pari. Scelta ben nota a chi ha letto il regolamento della VQR, ma anche facilmente verificabile attraverso la lettura del Rapporto finale VQR.

Affermazione che suona strana a chiunque conosca le procedure adottate dalla VQR nelle aree 10, 12 e 14. Infatti, non ha senso parlare di una sola area con maggiore percentuale di peer review rispetto alle altre perché, in tutte e tre, il 100% dei prodotti è passato attraverso la revisione dei pari. Scelta ben nota a chi ha letto il regolamento della VQR, ma anche facilmente verificabile attraverso la lettura del Rapporto finale VQR.

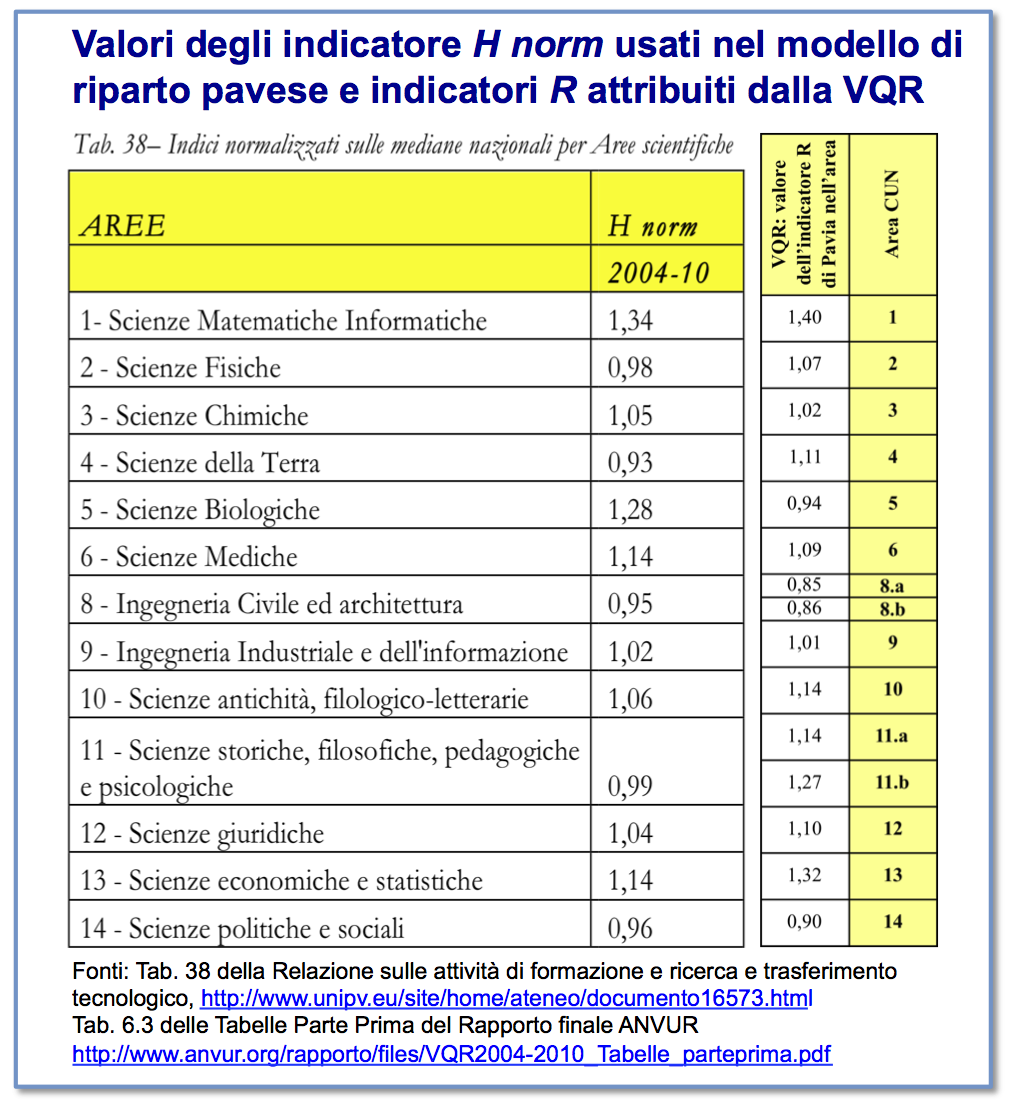

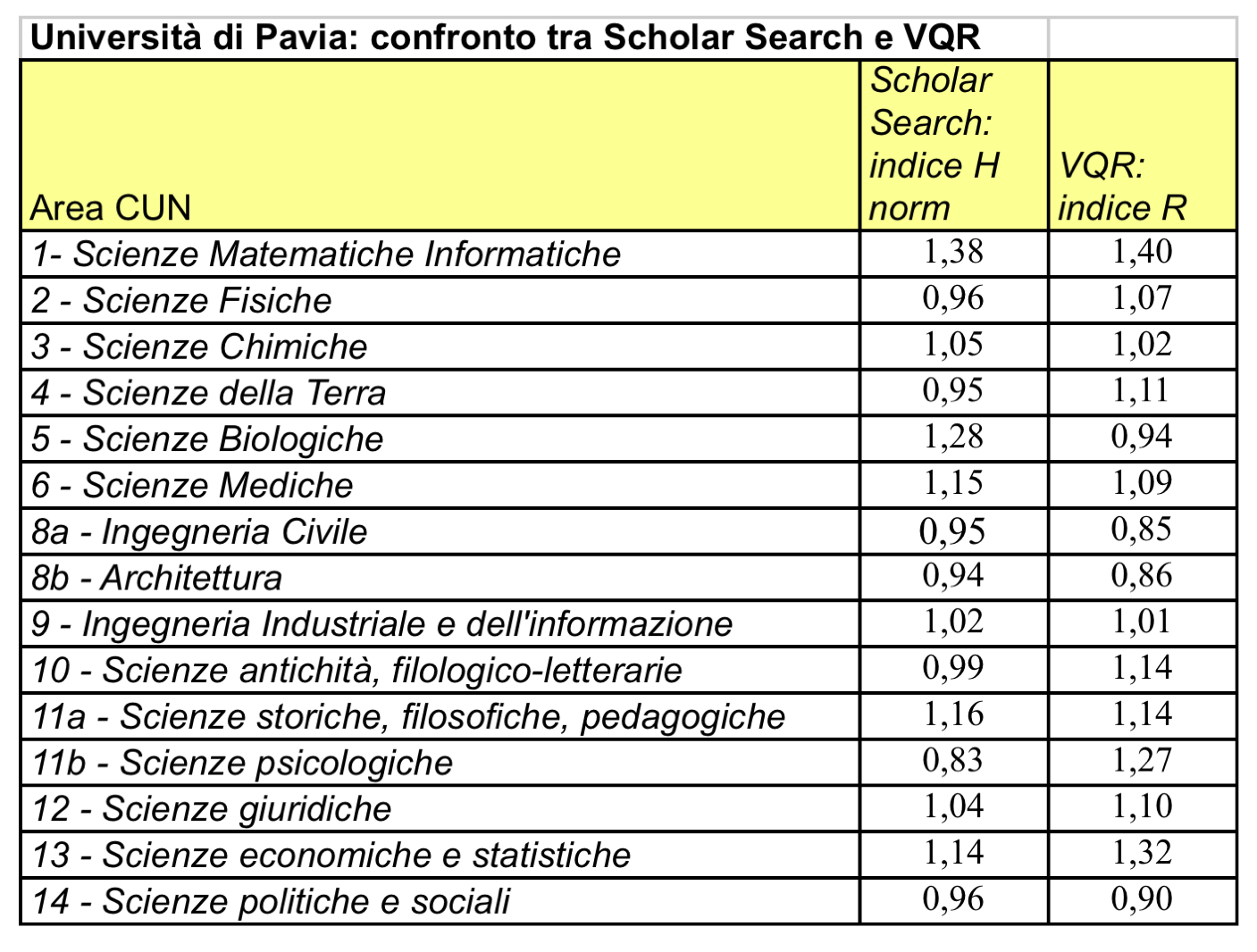

Veniamo ora però alla cattura del topo. Per poterla verificare, controlliamo se effettivamente ci sia “una discreta correlazione ed una accettabile co-graduazione” tra l’indicatore H norm usato nel modello di riparto pavese e l’indicatore R attribuito dalla VQR. Nella tabella seguente, sono riportati i numeri da confrontare.

Come si può vedere, sorge un problema con le Aree 8 e 11. Infatti, nella VQR sono state entrambe suddivise in una sotto-area bibliometrica (8a e 11b) e in una sotto-area non bibliometrica (8b e 11a), ragion per cui nella VQR compaiono voti distinti per le sotto-aree. Questa distinzione non esisteva nel modello di valutazione pavese. Per poter procedere con il confronto, abbiamo chiesto a Rampa i risultati dell’interrogazione di Scholar Search in base alla quale sono stati calcolati gli indicatori H norm. In tal modo, è stato possibile ricalcolare H norm anche per le sotto-aree 8.a, 8.b, 11.a e 11.b, ottenendo i risultati riportati nella tabella sottostante.

Come si può vedere, sorge un problema con le Aree 8 e 11. Infatti, nella VQR sono state entrambe suddivise in una sotto-area bibliometrica (8a e 11b) e in una sotto-area non bibliometrica (8b e 11a), ragion per cui nella VQR compaiono voti distinti per le sotto-aree. Questa distinzione non esisteva nel modello di valutazione pavese. Per poter procedere con il confronto, abbiamo chiesto a Rampa i risultati dell’interrogazione di Scholar Search in base alla quale sono stati calcolati gli indicatori H norm. In tal modo, è stato possibile ricalcolare H norm anche per le sotto-aree 8.a, 8.b, 11.a e 11.b, ottenendo i risultati riportati nella tabella sottostante.

Nel rifare i calcoli, è risultato che il valore di H norm per l’Area 10 risultava pari a 0,99, diverso cioè da quel 1,06 riportato nei documenti ufficiali dell’ateneo. Rampa ci ha confermato che nella stesura della Relazione 2012 (Aprile) sulle attività dell’ateneo pavese, i valori dell’area 10 e 11 erano risultati erroneamente invertiti, propagando un errore strutturale di Scholar Search (un tool non popriamente a prova di bomba, a quanto pare). L’errore avrebbe dovuto essere corretto nella Relazione 2013, ma a causa di un incauto copia-e-incolla è rimasto immutato. Il nostro ricalcolo di H norm ha fornito valori leggermente diversi da quelli di Rampa anche per altre aree: a quanto pare, Scholar Search era stato interrogato più volte in diverse date e, a quasi due anni di distanza, non si è riusciti a rintracciare i risultati precisi dell’interrogazione che aveva fornito i dati riportati nella Relazione 2012.

Nel rifare i calcoli, è risultato che il valore di H norm per l’Area 10 risultava pari a 0,99, diverso cioè da quel 1,06 riportato nei documenti ufficiali dell’ateneo. Rampa ci ha confermato che nella stesura della Relazione 2012 (Aprile) sulle attività dell’ateneo pavese, i valori dell’area 10 e 11 erano risultati erroneamente invertiti, propagando un errore strutturale di Scholar Search (un tool non popriamente a prova di bomba, a quanto pare). L’errore avrebbe dovuto essere corretto nella Relazione 2013, ma a causa di un incauto copia-e-incolla è rimasto immutato. Il nostro ricalcolo di H norm ha fornito valori leggermente diversi da quelli di Rampa anche per altre aree: a quanto pare, Scholar Search era stato interrogato più volte in diverse date e, a quasi due anni di distanza, non si è riusciti a rintracciare i risultati precisi dell’interrogazione che aveva fornito i dati riportati nella Relazione 2012.

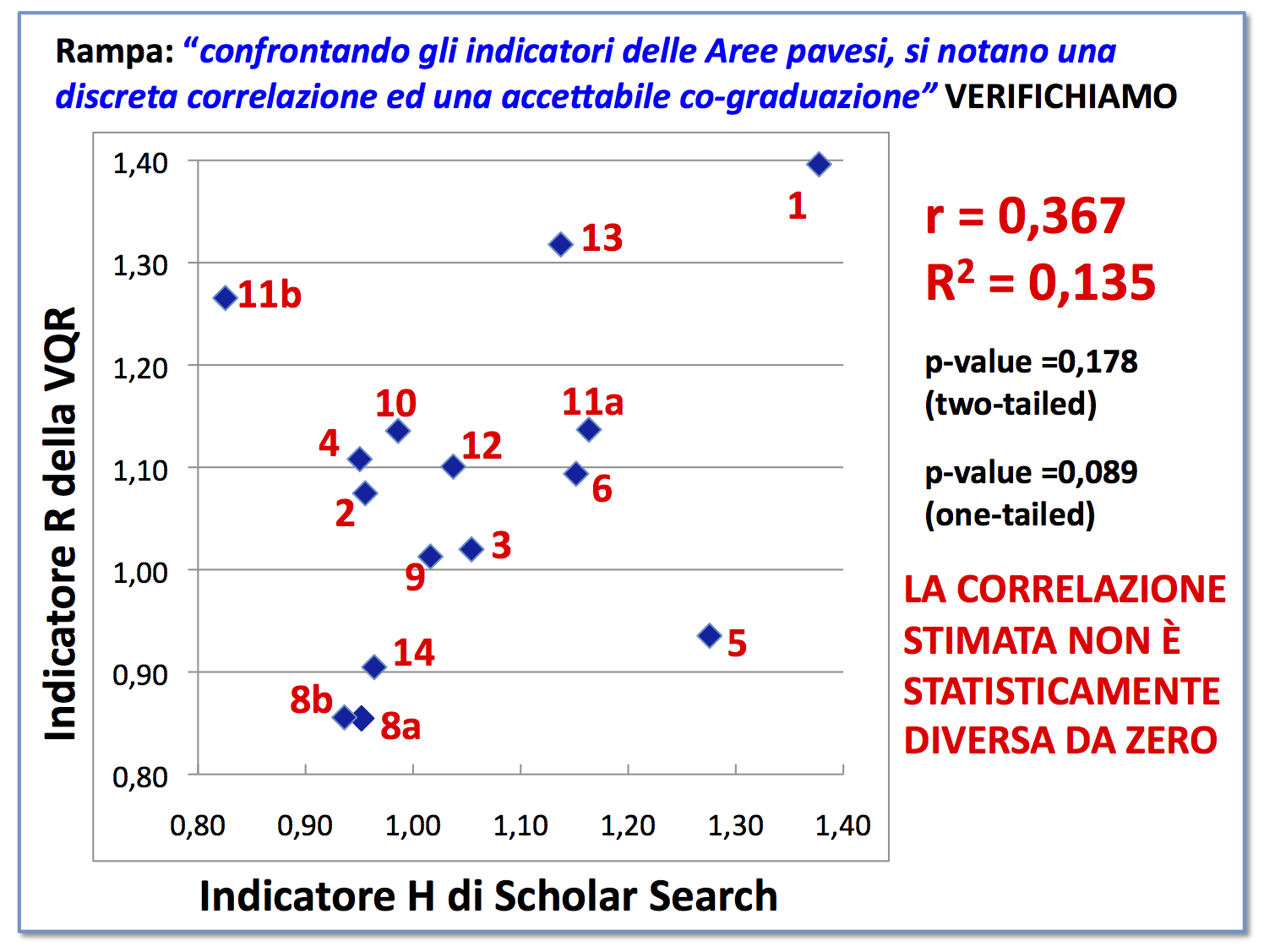

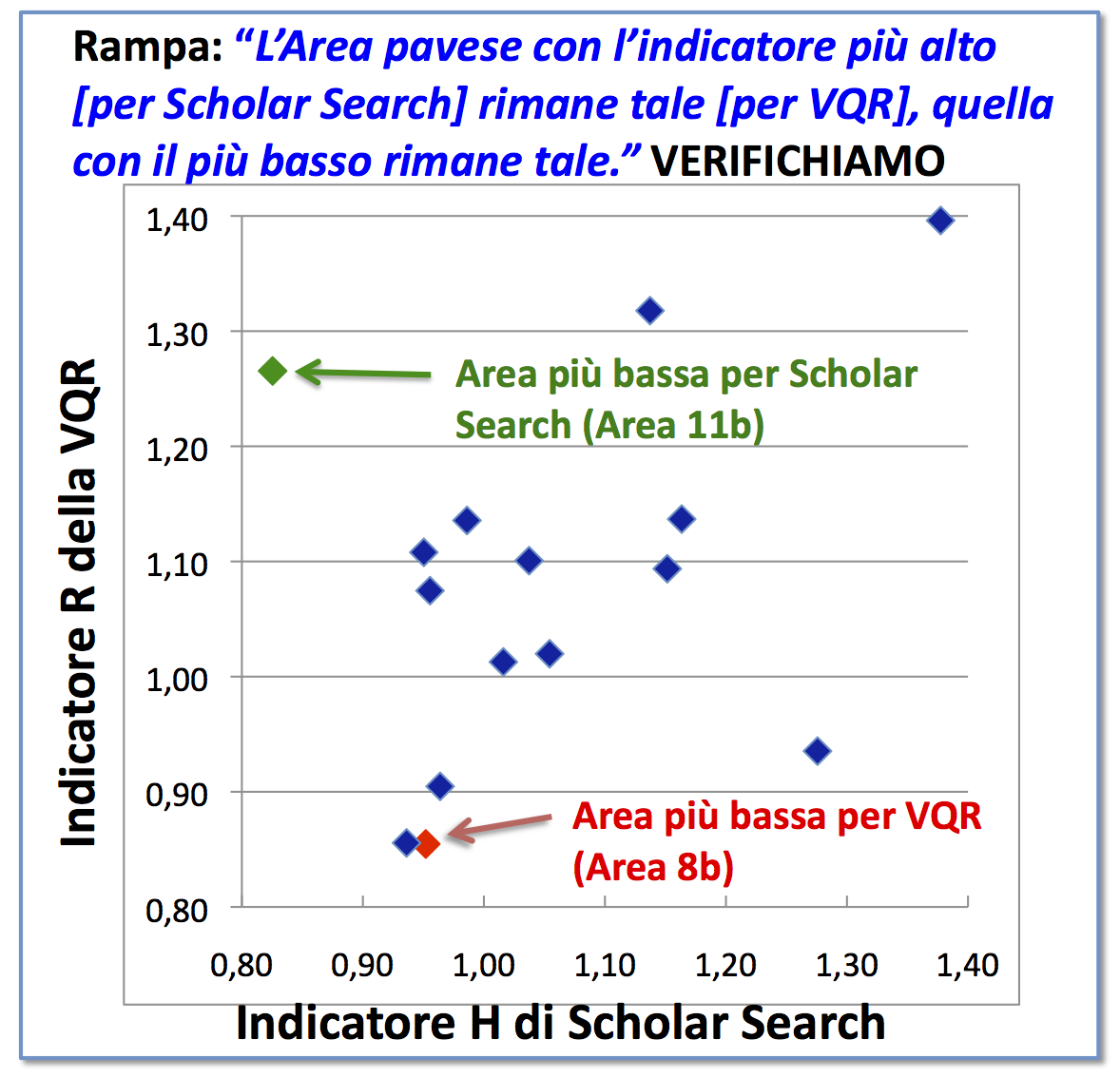

Avendo sistemato questi dettagli, possiamo venire al dunque. Costruiamo un grafico i cui due assi riportano H norm sulle ascisse ed R sulle ordinate. Se ci fosse perfetta concordanza, i punti dovrebbero disporsi su una linea diagonale che partendo in basso a sinistra punta in alto a destra. Non sembra che sia così, ma Rampa si ritiene comunque ragionevolmente soddisfatto della concordanza tra i due indici:

confrontando gli indicatori delle Aree pavesi, si notano una discreta correlazione ed una accettabile co-graduazione

In realtà, se si calcola il coefficiente di correlazione , si vede che esso non è statisticamente diverso da zero (si veda l’Appendice per i dettagli statistici). È arduo affermare che ci sia una “discreta correlazione”.

In realtà, se si calcola il coefficiente di correlazione , si vede che esso non è statisticamente diverso da zero (si veda l’Appendice per i dettagli statistici). È arduo affermare che ci sia una “discreta correlazione”.

Per fare qualche esempio, l’Area 11.b (Scienze psicologiche) ottiene il più basso valore di H norm (e quindi il peggior voto nella pagella pavese) ma le viene assegnato il terzo più grande valore di R (e quindi il terzo miglior voto nella pagella ANVUR). L’Area 5 (Scienze Biologiche), che a Pavia otteneva un brillante secondo posto secondo H norm, quando viene giudicata dalla VQR tramite l’indicatore R precipita al quartultimo posto.

Ebbene, Rampa sosteneva che

L’Area pavese con l’indicatore più alto [per Scholar Search] rimane tale [per VQR], quella con il più basso rimane tale.

Da un lato, è vero che la medaglia d’oro secondo Scholar Search, ovvero l’Area 1 (Scienze Matematiche e informatiche) si conferma tale per la VQR. Tuttavia, come si può vedere nella figura seguente, non è vero che la maglia nera secondo Scholar Search (Area 11b in verde) coincida con la maglia nera per la VQR (Area 8b in rosso).

In conclusione, Scholar Search non viene “sdoganato” dalla VQR. Anzi, se dovessimo prestar fede ai risultati della VQR, emergerebbe una preoccupante arbitrarietà dei valori dell’indicatore H norm. A questo punto, è lecito domandarsi quanto casuali fossero le valutazioni della ricerca utilizzate nel modello di riparto proposto da Rampa.

4. “Nessuno è perfetto”

Nella sua replica, Rampa ha cercato di far virare la discussione sul versante ideologico (valutazione sì o no). Ciò non solo significa andare fuori tema, ma non è rilevante per la valutazione dell'(in)adeguatezza della metodologia precedentemente adottata dell’ateneo. Una veloce verifica permette di accertarsi che Barbieri e De Nicolao non hanno scritto nulla su Agorà o altrove che assomigli ad una richiesta di perfezionismo nella valutazione. Si sono limitati a dimostrare con dati e numeri che l’uso di Scholar Search è un esempio di bricolage bibliometrico di qualità alquanto scadente.

Sostenere che un maldestro fai-da-te bibliometrico sia l’unica via alla valutazione appare tesi difficilmente sostenibile, come pure appare privo di fondamento imputare un eccesso di perfezionismo a chi denuncia grossolani errori. Qui c’è una fallacia logica: come se segnalare un errore in un’equazione significasse essere nemici della matematica.

Perché Rampa usa un argomento così debole, una delle tante varianti della “straw man fallacy“? Un deliberato espediente retorico per sviare la discussione dal piano tecnico? Un tentativo di additare gli interlocutori come “nemici della valutazione” che, anche quando dicono cose giuste, rimangono comunque degli irrecuperabili Luddisti fuori dalla storia?

Forse la ragione è diversa. Ai cultori del fai-da-te sfugge la distanza che esiste tra lo stato dell’arte della disciplina e le soluzioni da loro proposte di cui, sono comprensibilmente fieri. Da un lato, si può essere grati a Rampa per aver svolto per anni una funzione di supplenza in un campo che esula dalle sue competenze professionali, anche a costo di esporsi personalmente. Dall’altro, bisogna prendere atto che negli ultimi decenni la cultura della valutazione ha fatto passi da gigante. Esiste una sterminata letteratura tecnica e scientifica e si può ben dire che è tramontata l’età eroica delle soluzioni fatte in casa, escogitate da volenterosi pionieri.

A Rampa sembra accettabile la valutazione casereccia di Scholar Search. D’altronde, non tutti sono sensibili al rigore della scienza bibliometrica e c’è anche chi è insofferente agli orpelli della significatività statistica. Se a lui piace così, che male c’è? A maggior ragione, se come osserva Rampa, anche gli organi di governo si erano adeguati ai suoi gusti. “De gustibus non est disputandum“, aggiungerà qualcuno.

Eppure …

Nel finale della commedia “A qualcuno piace caldo“, le avances del miliardario Osgood Fielding nei confronti di Jack Lemmon (travestito da donna) diventano talmente insistenti che, per trarsi d’impaccio, quest’ultimo rivela la propria identità sessuale.

Nel finale della commedia “A qualcuno piace caldo“, le avances del miliardario Osgood Fielding nei confronti di Jack Lemmon (travestito da donna) diventano talmente insistenti che, per trarsi d’impaccio, quest’ultimo rivela la propria identità sessuale.

«Ma io sono un uomo!»

esclama esaperato Jack Lemmon, solo per sentirsi rispondere dallo spasimante, per nulla turbato,

«nessuno è perfetto!»

Tutto ciò è molto umano: anche di fronte all’evidenza di un errore, è difficile ammettere che l’oggetto della nostra ammirazione sia qualcosa di diverso da quello che si sperava. “De gustibus non est disputandum“, aggiungerà qualcuno.

Eppure …

Sì, Osgood ha tutta la nostra comprensione per la sua perseveranza che non desiste nemmeno quando cade il travestimento.

Eppure, né i suoi gusti né la nostra comprensione possono levarci dagli occhi l’evidenza del suo sbaglio.

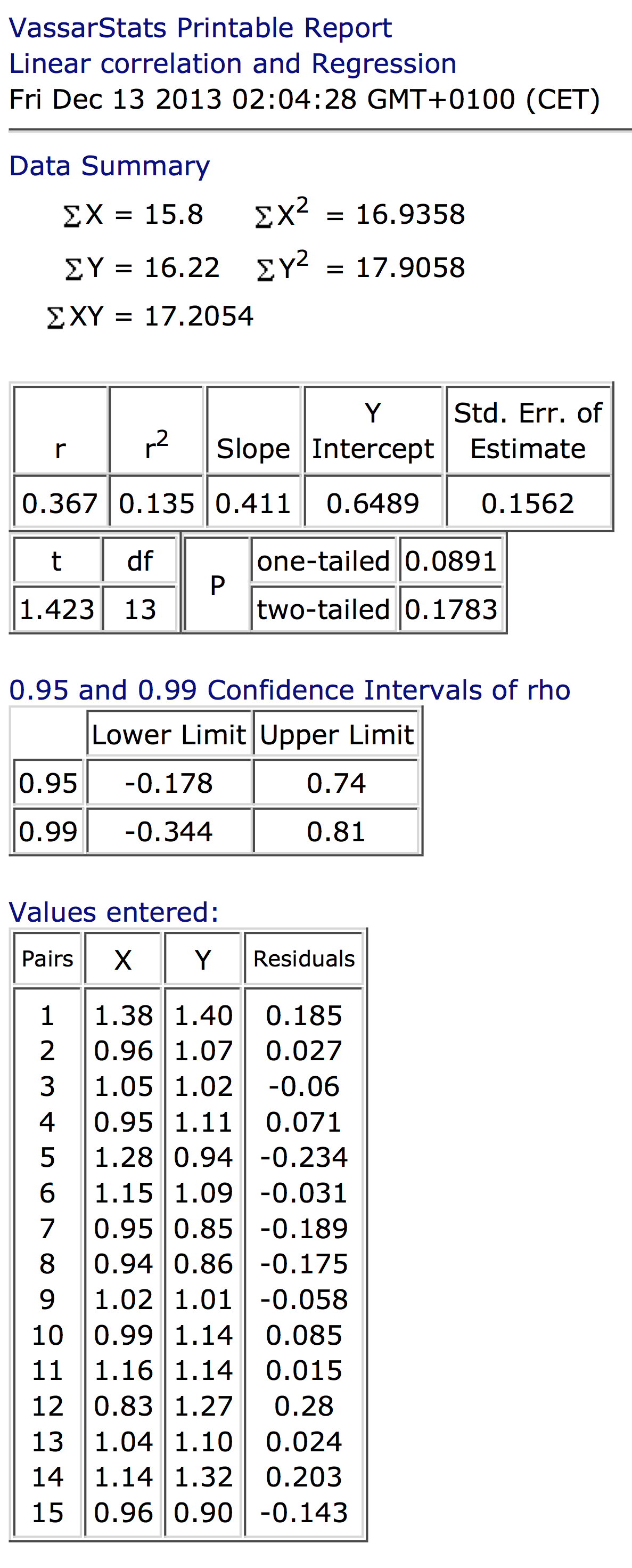

APPENDICE: analisi di correlazione tra indicatore R della VQR e H norm di Scholar Search

Pingback: Rampa in salita per il NuV | www.circoloerreraunipv.it

Pingback: Lorenzo Rampa: risposta a De Nicolao | www.circoloerreraunipv.it