Riceviamo e volentieri pubblichiamo la replica del Prof. Lorenzo Rampa all’articolo “Some like it wrong” – Risposta a Rampa di Giuseppe De Nicolao, precedentemente pubblicato sul nostro blog.

Giuseppe De Nicolao va ringraziato per l’infaticabile attività di critica alle esperienze di valutazione e al loro utilizzo nella prospettiva di un miglioramento progressivo della loro base scientifica e metodologica. Nella risposta al mio intervento su Agorà a proposito del Piano triennale trascura molti aspetti dello stesso per concentrarsi sul vaglio della questione da me posta di “quanto sia stato azzardato e (gravemente) compromissorio utilizzare in via provvisoria l’indice stesso (H norm) anche per Aree con un basso tasso di copertura della produzione scientifica”. Va da sé che la questione riguardasse sia la correttezza dei criteri di costruzione dei dati che l’aspetto delle conseguenze di quell’utilizzo sul riparto delle risorse del Piano Triennale del personale.

1. Riguardo alle conseguenze di quell’utilizzo sul riparto delle risorse nel mio intervento non ho portato fino in fondo l’argomento, nonostante che l’imputazione di eccessiva fretta nel decidere un’anticipazione di punti organico ai Dipartimenti pur nell’imminenza della pubblicazione dei risultati della VQR meritasse di essere maggiormente discussa.

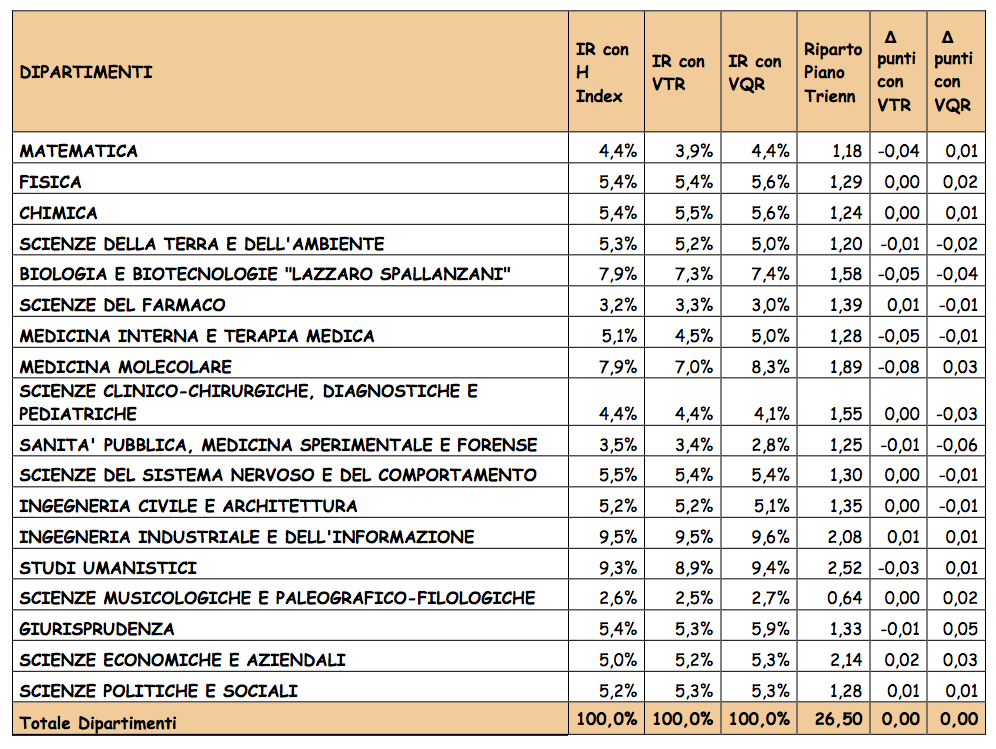

Nella Tabella qui riportata si possono leggere i valori dell’indicatore di ricerca (IR) ottenuti se si fossero utilizzati indicatori desunti dalla valutazione VTR (datati ma disponibili e allora proposti in alternativa all’ indicatore H norm) oppure desunti dalla VQR (al momento non ancora disponibili)[1].

Nelle ultime tre colonne si possono poi vedere il riparto dei punti tra i Dipartimenti decisa dagli Organi di governo nonché gli scarti dallo stesso che si sarebbero verificati adottando diversi indicatori di ricerca. Le differenze in termini di punti organico sono trascurabili e, ritengo, tali da non determinare gravi compromissioni delle future rimodulazioni del Piano triennale. Più significative sono le differenze negli indicatori di ricerca. A proposito di questi ultimi devo tuttavia ricordare che nella mia replica avevo comunque evidenziato come, in ogni caso, i dati VQR necessitassero di ulteriori elaborazioni a causa della loro eterogeneità[2]. Dunque il senso della Tabella è esclusivamente quello di dare un’idea degli ordini di grandezza delle differenze determinate dall’utilizzo di indicatori alternativi ai fini del riparto. Anticipo subito, tuttavia, che mi attendo da De Nicolao una critica radicale a questo esercizio che si basa sulla possibilità di aggregare gli indicatori VQR di Aree diverse (per i suoi argomenti si veda ad esempio il recente contributo su ROARS: http://www.roars.it/online/vqr-da-buttare-persino-anvur-cestina-i-voti-usati-per-lassegnazione-ffo-2013).

2. La critica cruciale di De Nicolao riguarda però la mia affermazione circa la “discreta correlazione”tra gli indicatori di Area utilizzati in quell’occasione e desunti da Scholar Search (d’ora in poi SS) e quelli desunti dalla VQR. Devo ammettere che tale affermazione, fatta a sostegno della mia tesi di non grave compromissione, doveva essere meglio precisata per essere sottoposta ad un vaglio tecnicamente rigoroso come quello proposto da De Nicolao.

La mia asserzione infatti riguardava palesemente il confronto tra dati a 14 (per Pavia 13) Aree CUN. Essi costituiscono aggregazioni di circa un migliaio di dati individuali diversamente normalizzati da SS e da VQR e raggruppati secondo criteri disciplinari in un numero molto basso di Aree di dimensione assai diversa. Ciò pone diversi problemi tra cui i principali sono: (a) la difficoltà di assumere la validità delle ipotesi statistiche che supportano i test standard di correlazione a causa della scarsa numerosità delle osservazioni e (b) la difficoltà di eliminare le distorsioni derivanti dall’eterogeneità intrinseca alle serie. Le cause principali di eterogeneità sono ovviamente dovute alla diversità dei criteri di misura e di normalizzazione, come avevo chiaramente premesso, oltre che alle differenze dimensionali delle Aree. Vi era dunque da attendersi che la significatività della correlazione potesse essere sensibile al livello prescelto di aggregazione. Non era però mia intenzione affrontare tutti questi problemi e l’enunciato, effettivamente piuttosto vago, era basato su livelli di significatività di poco al di sotto di quelli usualmente richiesti[3]. Non ho invece ritenuto, ai fini assai più modesti della mia replica, di procedere ad analisi statisticamente più fini.

De Nicolao sottopone la mia affermazione a prova statistica mediante minimi quadrati ordinari a livello di 15 Aree seguendo la classificazione VQR. I suoi risultati sono ineccepibili e vedono peggiorare in misura non trascurabile la significatività della correlazione. Come è ineccepibile l’evidenza delle rilevanti differenze tra valori degli indicatori di alcune Aree. La responsabilità principale della perdita di significatività della correlazione passando da 13 a 15 Aree è dovuta all’aumento dell’eterogeneità dimensionale. Infatti due aree generate dalla classificazione ANVUR, la 8.b e la 11.b, quella caratterizzata dal più elevato scarto tra i valori dei due indicatori[4], hanno dimensione inferiore al 1,5% a fronte di una dimensione media di 6,67%.

3. Le considerazioni precedenti inducono a ritenere che la correlazione migliorerebbe se si riducessero le due principali fonti di eterogeneità, quella dimensionale e quella relativa ai diversi criteri di misura e di normalizzazione (sulla deviazione standard di ogni SSD per SS e sulle medie di Area per ANVUR). In particolare le deviazioni standard, di cui ANVUR non tiene conto, sono molto diverse nei diversi aggregati, e più alte nelle Aree (tra cui ho segnalato ad esempio la 6 e la 13) con elevate percentuali di penalizzazione nei dati VQR.

Ad esempio se si utilizzassero come aggregati i 17 Dipartimenti pavesi attivi alla data di riferimento della valutazione VQR, ovviamente caratterizzati da minore eterogeneità dimensionale[5], si otterrebbe un notevole aumento di significatività della correlazione[6]. Vi è da attendersi inoltre che questa aumenterebbe ancora se si tenesse conto delle penalizzazioni incorporate nei dati VQR[7]. Risultati non particolarmente diversi si otterrebbero con dati riferiti al livello dei 18 Dipartimenti che, dopotutto, costituisce quello rilevante in questa discussione[8]. Naturalmente questi esercizi hanno solo un valore largamente preliminare, in quanto il loro uso a fini predittivi richiederebbe un più attento raffinamento dei dati ed una selezione più accurata del modello di stima.

Come avevo anticipato più sopra, mi aspetto le possibili obiezioni di De Nicolao per aver aggregato dati riferiti a Aree diverse e dunque, a suo giudizio, incomparabili e in-aggregabili per loro natura Sotto questo profilo credo che il dissenso tra noi riguardi la possibilità di migliorare l’affidabilità dei dati stessi e la loro utilizzabilità a scopi distributivi. Nella mia replica avevo fugacemente alluso a questa possibilità, invocando qualche metodo volto a ridurre gli effetti dell’eterogeneità e a evitare sovra o sottostime per alcuni Dipartimenti in cui prevalgono docenti e ricercatori afferenti ad Aree con varianze molto elevate (in parte dovute agli effetti delle penalizzazioni). Mi sembra però di capire che De Nicolao, dopo aver biasimato insieme a Barbieri l’assegnazione di punti del Piano triennale prima dell’uscita dei dati VQR, e poi raccomandato cautele nell’uso degli stessi (VQR: maneggiare con cura), sia infine pervenuto alla conclusione che essi siano da rigettare completamente (VQR da buttare?). Ma allora che fare? Cosa suggerire al governo dell’Ateneo ai fini della rimodulazione del Piano triennale? Ricominciare tutto da capo con una valutazione interna? Non tener conto di alcuna valutazione, per quanto imperfetta, nella distribuzione delle risorse? Potrei attendermi una risposta del tipo: la distribuzione delle risorse è essenzialmente una questione di scelta politica e non tecnica. Ma una distribuzione motivata in termini esclusivamente politici è proprio ciò che preferirei evitare.

[1] Per i dettagli del calcolo dell’indicatore IR utilizzato ai fini del Piano triennale si può vedere http://www.unipv.eu/site/home/ricerca/dipartimenti.html Tabella 2. Gli indicatori dipartimentali VQR qui utilizzati sono tratti da http://www.anvur.org/attachments/article/609/ANVUR-CRUI_tabelle.zip, con l’avvertenza che i dati si riferiscono a soli 17 Dipartimenti pavesi (manca il Dipartimento di scienze del sistema nervoso e del comportamento non ancora attivato alla data di riferimento della valutazione VQR). Ciò ha richiesto alcune ulteriori elaborazioni che comportano qualche grado di imperfezione a causa dell’indisponibilità dei dati relativi ai voti di SSD con numero di prodotti inferiori a 10.

[2] I motivi da me addotti a favore della necessità di ulteriori elaborazioni non sono molto dissimili da quelli utilizzati da Giacomo Poggi nel Documento che accompagna i dati ANVUR CRUI citati nella Nota 1.

[3] Si ottiene infatti un F-value di poco inferiore al valore critico (4,40 vs 4,67) e un p-value 0,056 che equivale ad una significatività di poco inferiore al 95% usualmente richiesto. Le statistiche qui riportate sono state calcolate utilizzando, per ovvi motivi di comparazione, gli stessi dati pubblicati da De Nicolao (al secondo decimale).

[4] Il valore di H norm dell’Area 11.b calcolato da De Nicolao è più basso di quello che risulta dalla media dei dati individuali, ma ciò non cambia radicalmente le sue conclusioni.

[5] La dimensione minima è in questo caso 3,5% contro una media di 5,9%. I dati qui utilizzati corrispondono all’indicatore IDVA su medie di Area (in sostanza l’indicatore R della VQR) tratti da http://www.anvur.org/attachments/article/609/indicatore_Area_29_01_2014.xls.

[6] Le statistiche sono: F-value 13,44 vs un valore critico di 4,54, un t relativo al coefficiente d H norm (pendenza) di 3,65 e p-value 0,0024 che equivale ad una significatività superiore al 97%.

[7] In effetti utilizzando come ulteriore regressore un indicatore di penalizzazione relativa dei Dipartimenti pavesi si otterrebbe un notevole incremento di significatività, con segni dei coefficienti dei regressori coerenti con le attese (quello dell’indicatore di penalizzazione ovviamente negativo), F-value (20,39), t superiori alle soglie critiche (rispettivamente 2,98 e 2,05) e un p-value pari a 0,0005.

[8] Ho evitato di replicare le regressioni utilizzando osservazioni riferite ai 18 Dipartimenti attuali poiché esse risentirebbero delle imperfezioni riferite nella precedente Nota 1.

Rampa: “Ma allora che fare? Cosa suggerire al governo dell’Ateneo ai fini della rimodulazione del Piano triennale? Ricominciare tutto da capo con una valutazione interna? Non tener conto di alcuna valutazione, per quanto imperfetta, nella distribuzione delle risorse? Potrei attendermi una risposta del tipo: la distribuzione delle risorse è essenzialmente una questione di scelta politica e non tecnica. Ma una distribuzione motivata in termini esclusivamente politici è proprio ciò che preferirei evitare.”

=============

Credo che Rampa debba rimproverare più l’ANVUR che De Nicolao in relazione alla distribuzione motivata in termini politici. Infatti. la natura politica delle distribuzione delle risorse tra diverse aree è stata imposta dalle scelta tecniche (che ritengo errate) dell’ANVUR, la quale scrive molto chiaramente:

________________

“le tabelle che per comodità di visualizzazione riuniscono nel rapporto i risultati delle valutazioni nelle varie Aree non devono essere utilizzate per costruire graduatorie di merito tra le aree stesse, un esercizio senza alcun fondamento metodologico e scientifico. […]

La definizione dei pesi , la scelta di quale indicatore finale utilizzare e dei valori dei pesi α e β non è compito dell’ANVUR, ma è una scelta di natura “politica” di competenza del MIUR. Una possibile scelta per i pesi può essere finalizzata a orientare la ricerca futura privilegiando alcune aree rispetto ad altre, oppure può riflettere in maniera neutra la quota dei prodotti conferiti o dei ricercatori delle diverse aree o, ancora, può essere proporzionale alla quota di finanziamenti storicamente assegnati alle aree (ad esempio nei bandi PRIN e FIRB o europei).”

http://www.anvur.org/rapporto/files/VQR2004-2010_RapportoFinale_parteprima.pdf

________________

Come osservato sopra, nemmeno l’ANVUR crede più che siano confrontabili i voti tra diversi SSD. Se l’ANVUR fosse coerente, dovrebbe dire che anche le ripartizioni tra SSD sono decisioni di natura politica e dovrebbe rinnegare la ripartizione della quota premiale FFO 2013.

Che fare adesso? Io (come avevo detto nel mio seminario a Pavia: slide #128, http://www.circoloerreraunipv.it/wordpress/?p=344 ) ribalterei i criteri politici nazionali anche sulla ripartizione locale. Dopo tutto, la quota di FFO premiale attribuita all’ateneo è stata calcolata con quei criteri politici (right or wrong). Allora, la cosa più semplice è dare ad ognuno il suo. Mi sembra una soluzione salomonica che propaga ai dipartimenti gli errori della VQR e le scelte politiche del ministro. Magari non è bello propagare errori, ma è in base a quegli errori che sono arrivati i soldi. Se l’ateneo ha preso più di quel che meritava perché la VQR ha sopravvalutato un’area, adeguiamoci anche noi. Infatti, la VQR è talmente mal progettata da non essere emendabile. Non credo che esistano artifizi statistici capaci di restituirci la “giusta VQR”. Accontentiamoci di quella sbagliata, tanto più che è stata già usata per dividere la torta. Però, cerchiamo di fare tesoro della lezione per il futuro, mandando a casa gli apprendisti stregoni che ci hanno ficcato in questo vicolo cieco.

Rampa: “Mi sembra però di capire che De Nicolao, dopo aver biasimato insieme a Barbieri l’assegnazione di punti del Piano triennale prima dell’uscita dei dati VQR, e poi raccomandato cautele nell’uso degli stessi (VQR: maneggiare con cura), sia infine pervenuto alla conclusione che essi siano da rigettare completamente (VQR da buttare?).”

=====================

Riguardo ai dubbi sull’affidabilità dei voti VQR sono in buona compagnia: in una presentazione Giacomo Poggi (Commissione ricerca della CRUI) ha scritto:

_____________________

– le distribuzioni nazionali dei voti nei vari SSD sono molto differenti:

– Differiscono i valori medi […];

– Differiscono le larghezze, cioè le dispersioni dei voti […]

– Spesso nei SSD bibliometrici: valutazioni assai più compatte e mediamente più elevate.

– Spesso nei SSD non bibliometrici domina l’effetto “discrezionalità”: maggiori “larghezze” della distribuzione e valori medi inferiori.

– Il campo di votazioni “normali” (non solo le votazioni medie) varia da SSD a SSD.

– Un problema non piccolo.

_____________________

La consapevolezza delle distorsioni presenti nei voti VQR sta dando luogo ad una serie di aggiustamenti, anche in contrasto tra loro:

_____________________

1. l’ANVUR nel documento sull’accreditamento dei dottorati (http://www.anvur.org/attachments/article/455/accreditamento%20corsi%20di%20dottorato.pdf) abbandona i voti originali e dichiara di voler escludere “fannulloni integrali” e “fannulloni a 2/3” (tenendo però i fannulloni a 1/3) e di voler normalizzare dividendo per il voto medio di SSD e non più di Area CUN (sembra proprio la risposta alla critica CRUI appena menzionata)

_____________________

2. La CRUI ritiene inadeguata la nuova normalizzazione dell’ANVUR e propone una terza versione degli indicatori in cui si normalizza tenendo conto di media e varianza dei voti dei singoli SSD. Ho mostrato altrove (http://www.roars.it/online/voti-vqr-ai-dipartimenti-le-normalizzazioni-fai-da-te-di-crui-e-anvur/) che le ipotesi di questa normalizzazione sono smentite dei dati con il risultato che gli indicatori dei dipartimenti, lungi dall’essere stati normalizzati in base alla loro vera statistica, si trovano a dipendere dalle ipotesi arbitrarie che definiscono il cosiddetto “Dipartimento Virtuale Associato” (DVA), un modello astratto che è nettamente respinto se sottoposto a test di verifica di ipotesi.

_____________________

3. A seguito delle mie critiche, la Commissione Ricerca della CRUI ha precipitosamente rivisto le sue tabelle ed ha introdotto un nuovo indicatore IPR per cercare di mettere rimedio alle distorsioni introdotte dal DVA.

_____________________

La cosa interessante è che le tabelle CRUI sono state pubblicate nella prima versione e poi sostituite dalla nuova versione (quella con l’indicatore IPR) proprio sul sito ANVUR (http://www.anvur.org/index.php?option=com_content&view=article&id=620:vqr-2004-2010-collaborazione-anvur-crui-it&catid=23:vqr-2004-2010&Itemid=188&lang=it) dove adesso convivono tre diverse metodologie per valutare gli esiti VQR:

_____________________

a) tabelle originali del luglio 2013

b) criteri normalizzati per SSD indicati nel documento accreditamento dottorati

c) tabelle CRUI normalizzate per SSD usano media e varianza e frullandole dentro il modello (arbitrario) del Dipartimento Virtuale Associato e rappezzando con il nuovo indicatore IPR.

_____________________

Una vera Babele in cui riesce persino difficile capire quale sia la versione della VQR con cui confrontarsi. Un po’ come la Concordia finita sugli scogli con L’ANVUR al posto di Schettino.